L'avenir de l'IA pour les smartphones est sur dispositif. Ou rendre autant de processus d'IA locaux que possible. Pourquoi? Eh bien, vous n'avez pas besoin d'une connexion Internet pour faire le travail. Qu'il s'agisse de demander à un chatbot de relire et de réparer les erreurs grammaticales, de faire de brèves recherches, d'édition d'images ou d'expliquer le monde qui vous entoure à travers la caméra.

Deuxièmement, aucune de vos données personnelles ne doit quitter l'appareil et être traitée sur un serveur distant. Et troisièmement, ça va être plus rapide. Plus un modèle est petit, plus il peut produire des résultats plus vite. C'est un peu une situation de concevoir. Un modèle AI léger signifie que ses capacités sont limitées.

Un modèle d'IA plus grand, comme Gemini ou Chatgpt, peut comprendre le texte, l'image, l'audio et même générer une vidéo. Ce sont de grands modèles, et ils nécessitent une sacrée tonne de puissance de traitement sur les puces personnalisées. En un mot, vous avez besoin d'une connexion Internet pour y arriver. Mais quelque chose de assez cool se prépare, et ce quelque chose vient de Google.

Qu'est-ce que cette application AI?

Il y a quelques mois, la société a présenté une application appelée Google AI Edge Gallery. Après être resté sur Github pendant un certain temps, il s'est finalement rendu au Play Store. Idéalement, c'est une application pour les développeurs qui cherchent à créer des expériences d'IA dans leurs applications, mais vous pouvez l'essayer sans perdre votre santé mentale.

Considérez-le comme un marché ou un magasin. Mais au lieu de trouver des applications, vous pouvez choisir des modèles d'IA pour exécuter sur votre téléphone. Si vous achetez un téléphone Android aujourd'hui, comme le Pixel 10 Pro, toutes les fonctionnalités de l'IA sont alimentées par les Gémeaux. Vous pouvez télécharger séparément des applications telles que Chatgpt ou Claude, mais elles nécessitent toutes une connexion Internet et envoient vos données aux serveurs.

La galerie Google AI Edge est spécifiquement conçue pour exécuter les modèles AI hors ligne. Donc, si vous voulez donner un sens à une image ou résumer un long rapport, vous pouvez tout faire hors ligne. Et voici la meilleure partie. Vous pouvez le faire en utilisant n'importe quel modèle d'IA de votre choix, sans installer une application dédiée pour cela.

En un mot, cette application est un guichet unique pour l'exécution d'expériences d'IA, totalement gratuites et sans aucune exigence de connexion Internet. Maintenant, pourquoi voudriez-vous faire ça? Eh bien, je peux penser à quelques situations.

Comment cette application est-elle utile?

Supposons que vous rencontriez votre limite de données cellulaires, trouvez-vous dans un endroit sans connexion Internet limitée, ou vous ne voulez tout simplement pas alimenter des rapports confidentiels à une IA en ligne. Peut-être que vous voulez une IA spécialisée qui ne fait qu'une tâche spécifique, comme transformer un fichier PDF en un pager avec des puces. Ou nourrir des images et obtenir une IA pour écrire du matériel académique basé sur eux.

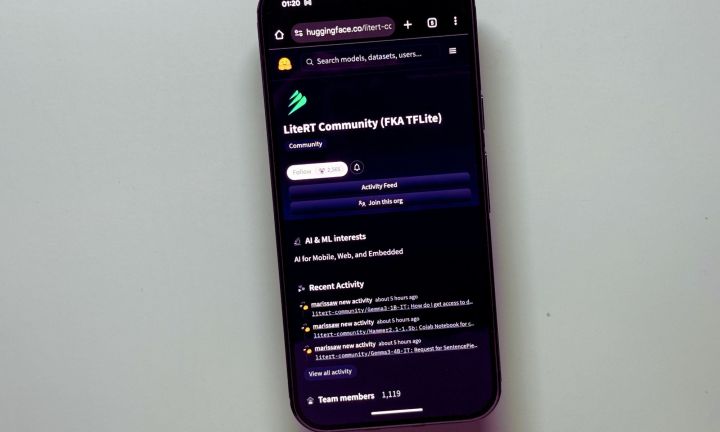

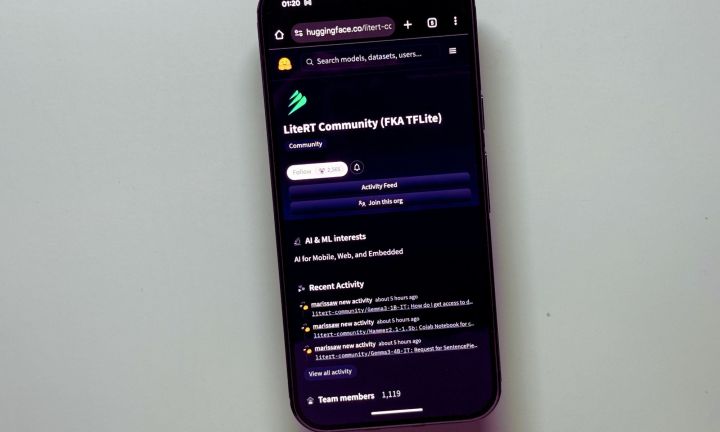

Pour tous ces scénarios, et plus encore, vous pouvez simplement vous tourner vers Google AI Edge Gallery, exécuter le modèle AI de votre choix et faire des choses. À l'heure actuelle, tous les modèles «compatibles» dont vous avez besoin peuvent être téléchargés à partir de la bibliothèque communautaire Huggingface Linet.

Ici, vous trouverez des modèles d'IA assez puissants développés par Google dans la série Gemma. Ceux-ci sont livrés avec des capacités multimodales, ce qui signifie qu'ils peuvent gérer le texte, l'image et la génération audio. Vous pouvez, Howevever, expérimenter avec d'autres modèles d'IA aussi, comme tels que Deepseek, Smolvlm, Microsoft's Phi-4 Mini et Meta's Llama.

Maintenant, permettez-moi de donner un bref aperçu technique. Tous ces modèles d'IA disponibles pour Google AI Edge Gallery sont optimisés pour l'exécution haute performance connue sous le nom de Linet, qui est spécifiquement adaptée aux tâches AI sur les appareils. Tout comme les modèles d'IA mentionnés ci-dessus, Linet est également un runtime open-source pour les modèles de grande langue (LLM).

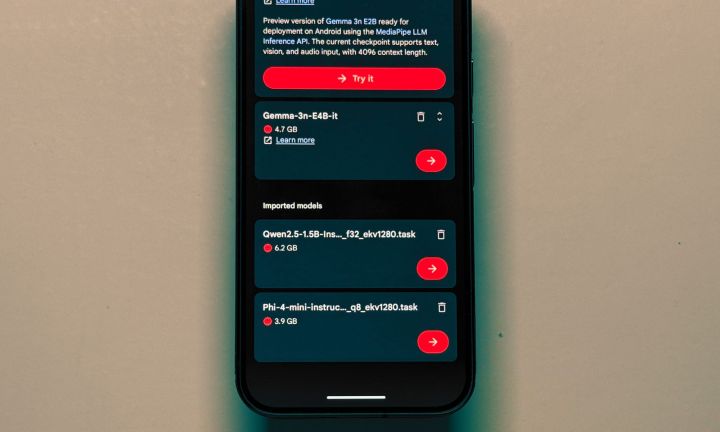

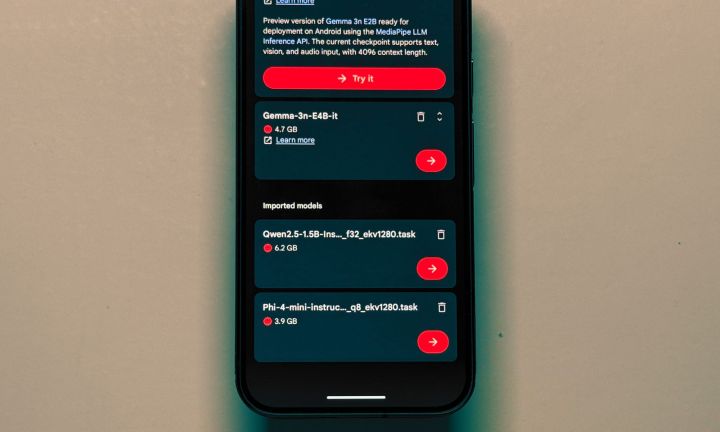

Si vous connaissez bien des outils tels que TensorFlow ou Pytorch, vous pouvez même importer n'importe quel modèle AI «compact» correctement stocké sur votre PC. Mais d'abord, vous devez convertir les fichiers au format de fichier .litertlm ou .task. Une fois sur place, il vous suffit de pousser le package dans le dossier «Télécharger» du téléphone et de l'importer dans la galerie Google AI Edge avec quelques robinets.

Comment est l'expérience?

J'ai surtout joué avec le modèle Gemma 3n, car celui-ci est le plus polyvalent du groupe. Mis à part les chats, il peut également traiter les images et générer de l'audio. Vous pouvez sélectionner si un modèle s'exécute sur CPU ou GPU, ajuster l'échantillonnage et la température.

Ce dernier, en termes les plus simples, est une mesure de la diversité des réponses d'une IA. La température plus basse produit des sorties plus prévisibles, définitives et un peu répétitives. Une température plus élevée produit essentiellement des réponses précises, mais avec une entrée créative supplémentaire et des chances d'erreur plus élevées.

Maintenant, vous n'avez pas nécessairement besoin de jouer avec ces champs. Expérimentez simplement la façon dont un modèle d'IA fonctionne sur CPU ou GPU en termes de taux de réponse, et en conséquence le maintenir. J'ai expérimenté environ neuf modèles, et le point à emporter a été mélangé.

Commençons par les différences. J'ai partagé une photo de mon chat et demandé aux Gémeaux d'identifier l'espèce. Il l'a fait en trois secondes. Lorsque la même requête a été poussée avant Gemma 3n, il a fallu 11 secondes. La réponse était exacte, mais un peu courte. Si vous préférez les réponses sur le point, vous pourriez même aimer cette approche. À l'occasion, vous pourriez rencontrer des erreurs, en particulier avec les requêtes multimodales, vous voulez donc changer l'accélérateur (CPU et GPU) et voir si cela accélère les choses.

De même, le traitement du texte peut également être un peu lent. Lorsque j'ai poussé un article d'une valeur d'environ 900 mots et demandé au modèle Qwen 2.5 d'Alibaba pour le résumer comme des puces, il a fallu son propre temps doux d'environ 20 secondes pour commencer. Le mini PHI-4 de Microsoft était sensiblement plus rapide au travail, mais j'ai aimé le formatage réfléchi de Qwen 2,5 de plus.

Le modèle GEMMA 3N-E2B a été le plus rapide à la tâche et a également livré la réponse la plus élevée en moins de huit secondes. Le plus puissant Gemma-3N-E4B a réussi à reformater et à formaliser le ton du même article en environ sept secondes tout en fonctionnant sur le CPU.

La transcription audio, bien que limitée aux clips de 30 secondes, est tout simplement fantastique. Le modèle GEMMA 3N-E2B de Google n'a pas fait une seule erreur et a fait un excellent travail en résumant le clip audio transcrit. Tout cela s'est produit en moins de 10 secondes.

Tous les modèles ne fonctionnent pas bien avec l'accélération GPU, vous devez donc les faire sortir du CPU. GEMMA3-1B a été coincé lors du traitement pendant des minutes. Essayer de changer le format d'accélération plante l'application, en particulier avec Qwen et PHI-4 Mini. Du côté positif, Phi-4 Mini était presque aussi rapide que Gemma dans certaines tâches de formatage d'articles tout en fonctionnant sur le CPU.

Un coup d'œil dans le futur

Maintenant, cette application ne fonctionnera pas sur tous les téléphones. À tout le moins, il a besoin d'un processeur avec une puissante puce d'accélérateur NPU ou IA, et de préférence, 8 Go ou plus de RAM. J'ai effectué mes tests sur Google Pixel 10 Pro, et il n'est pas devenu grillé. De plus, vous aurez besoin de connaissances techniques si vous souhaitez exécuter des modèles d'IA qui ne sont pas actuellement disponibles dans la galerie Linet.

Dans l'ensemble, l'application AI Edge Gallery de Google n'est pas tout à fait un remplacement pour les Gémeaux ou toute autre application de chatbot connectée à Internet sur votre téléphone. Du moins pas encore. Mais c'est un signe de choses brillantes à venir. Ne cherchez pas plus loin que l'application Huggingsnap, qui fonctionne sur un modèle open source, entièrement hors ligne, mais permet des capacités d'intelligence visuelle sur un iPhone.

À mesure que les processeurs mobiles deviennent plus adaptés à l'IA au niveau matériel, et nous obtenons plus de modèles d'IA optimisés pour les tâches sur les appareils, des applications comme Google IA Gallery pourraient en fait servir de plaque tournante de tâches d'IA utiles. Un hub plus privé, qui fonctionne entièrement en ligne, et n'en facture aucun frais.